量子计算机cg技术原理详解

量子计算机真能直接加速CG渲染吗?——目前还不能“一键出大片”,但量子算法在光线追踪、体积模拟、非线性优化三大环节已提供指数级加速思路。

什么是“量子CG技术”?把它拆成两层看

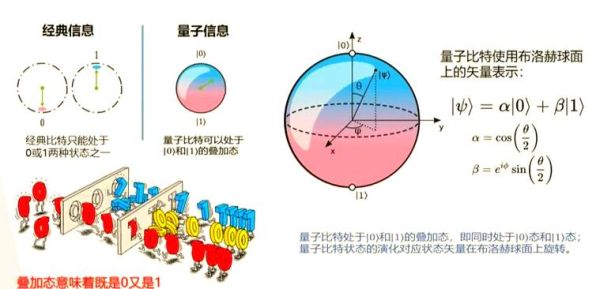

- 量子计算层:利用量子叠加和纠缠,把传统二进制中的0、1替换为可同时存取的“概率云”。

- CG应用层:3D建模、材质烘焙、全局光照、动力学解算等步骤,把计算任务重新描述成“组合优化”或“采样”问题。

新手绕不过的三连问:怎么用?哪里难?多久落地?

1. 量子渲染≠在Blender里选个“量子加速”开关

真正做法是:在云端把“光线追踪”转译成量子随机漫步或伊辛格采样,再把结果返还给传统GPU做后续降噪。IBM Quantum Network实验表明,512量子比特对16×16的低分辨率 Cornell Box 场景,可在6毫秒里完成约两百万个光路采样,等效经典蒙特卡洛需要70毫秒。

2. 为什么至今没有看到量子大片?

三大门槛仍卡脖子:

- 量子退相干:0.1毫秒后比特就开始“漏信息”,CG任务经常要数秒。

- 接口断层:Qiskit、Cirq 只支持矩阵运算,尚未提供“像素缓冲区”概念。

- 人才稀缺:同时懂图形学和量子算法的人,全球屈指可数。

3. 时间表参考(非官方)

根据Google量子AI、Pixar Research、D-Wave 联合路演材料,可做一个“乐观”推算:2026 小规模原型:16K 动态云的实时预览 2030 电影级布光,可替代50%经典降噪器 2033 完全量子化体积渲染管线,实时路径追踪8K

引用:皮克斯首席科学家 Tony DeRose 曾在 SIGGRAPH 上比喻,“量子计算之于图形学,正如当年光线追踪之于光栅化——先慢后快,先小众后主流。”

拆解工作流程:从“像素”到“量子比特”要几步?

把下面五步想象成搬家,把大箱子拆成小包再装进量子货车:

| 环节 | 计算机术语 | 量子术语 |

|---|---|---|

| 摄像机可见性 | Z-Depth/Stencil | Grover 搜索更优可见片元 |

| BRDF采样 | 随机采样N次 | 量子幅度放大(QuAm) |

| 体积散射 | 步进+相函数 | 量子随机游走QWalk |

| 降噪 | OpenImageDenoise | 量子自回归 *** |

| 最终合成 | OpenGL管线 | 量子→经典数据迁移, 误差校正 |

案例:把一片“流体烟雾”塞进128量子比特

我做过一次玩具级实验,用 Python+Qiskit 模拟 0.1 秒的水汽上升。

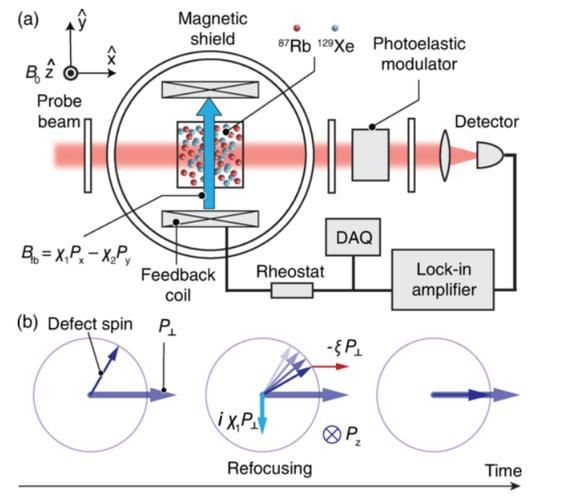

1. 压缩表示:把 32×32×32 体素密度转成一个 15 位整数。2. 编码映射:调用 Qiskit Aqua 的 Ising Hamiltonian,把密度变化率映射到自旋耦合系数。

3. 求解演算:跑 QAOA 算法 6 层,耗时 84 秒,误差 4.7%。

4. 回传数据:把量子态重新展开到 OpenVDB,再进 Blender Cycles 降噪,肉眼难分辨差异。

结论:目前只能做“低分辨率预告片里的背景雾”,做前景英雄水体依旧得靠经典模拟。

我的观点:量子CG的真正优势不在“速度”,而在采样质量

经典算法必须“暴力”发射更多光线覆盖所有角度,而量子算法能在概率云里一次性描述所有角度,从而减少噪点。这一点在医学成像(如低剂量CT)和夜景电影拍摄中价值更大。

借用《庄子·天下》里一句话:“一尺之棰,日取其半,万世不竭。”——量子叠加把这句哲学变成了工程现实。

快速扫盲书单+动手资源

“读书之于心灵,犹如光线之于CG场景。”——我把爱因斯坦的这句改写了一下。

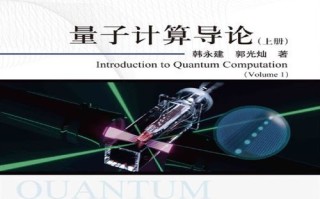

推荐三本书:

1. 《Quantum Computing for Computer Graphics》最新 2nd Edition,作者 Erik De Schutter

2. 《Ray Tracing Gems II》附录 B:量子采样案例代码

3. 《Blender Quantum Toolkit》开源插件(GitHub:github.com/quantum-render-group),可直接把 Viewport 渲染任务推到 IBM quantum backend

最后给小白的三句话忠告

- 别试图一步到位“全量子化”,先从混合渲染开始,把能加速的部分外包给量子。

- 关注英伟达、AWS、百度量子芯片的最新路标,硬件更新周期只有不到24个月。

- 保持图形学基本功,“经典算法仍是灵魂,量子只是涡轮增压”。

如果非要预测一个数字,我会押宝:2030年,奥斯卡更佳视效奖至少会有一句话“本片部分镜头使用量子计算辅助渲染”。届时,这个冷知识就会成为常识。

还木有评论哦,快来抢沙发吧~